2024 · AI“下凡”

ChatGPT带动云侧AI产业链史诗级爆发

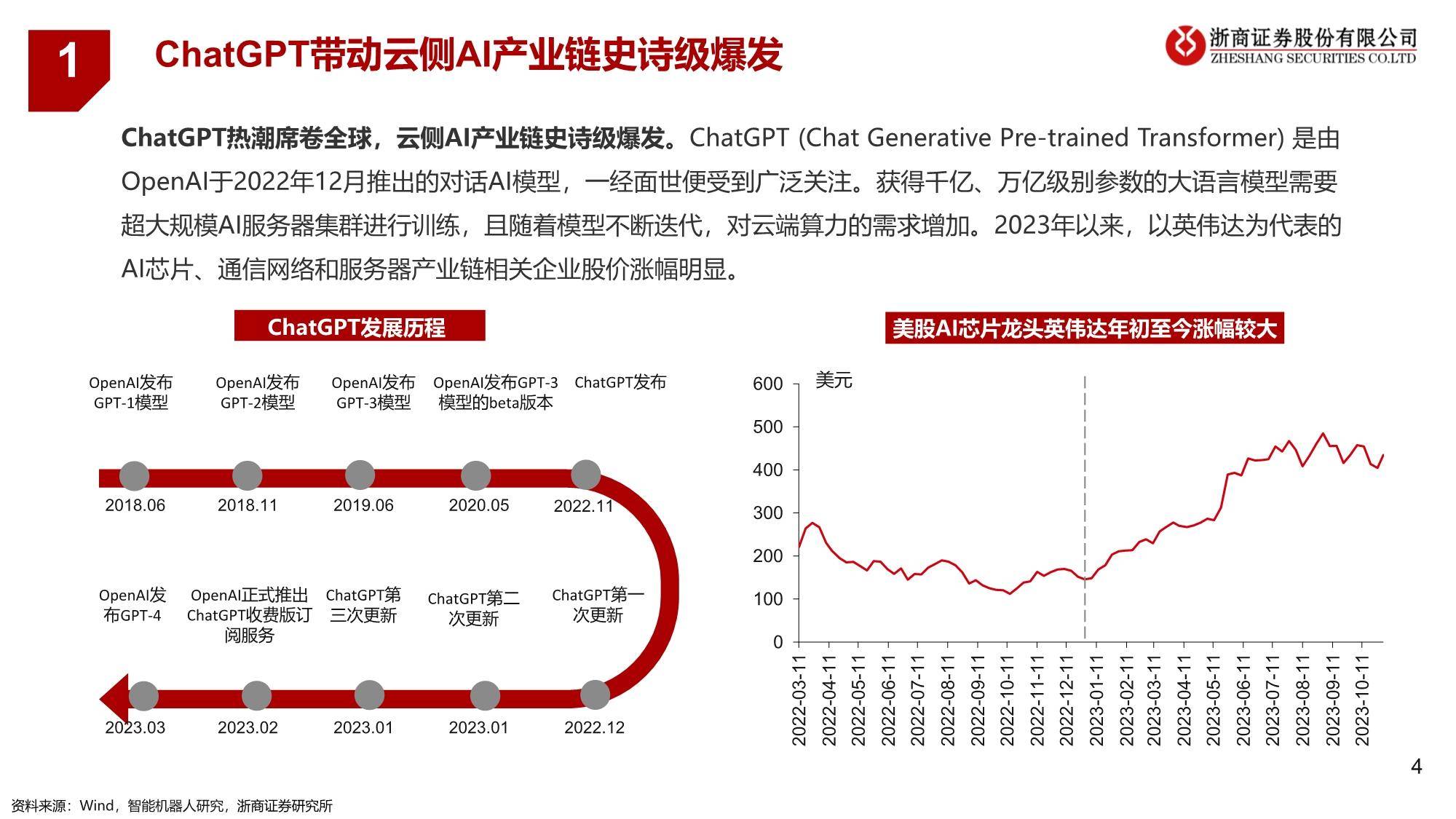

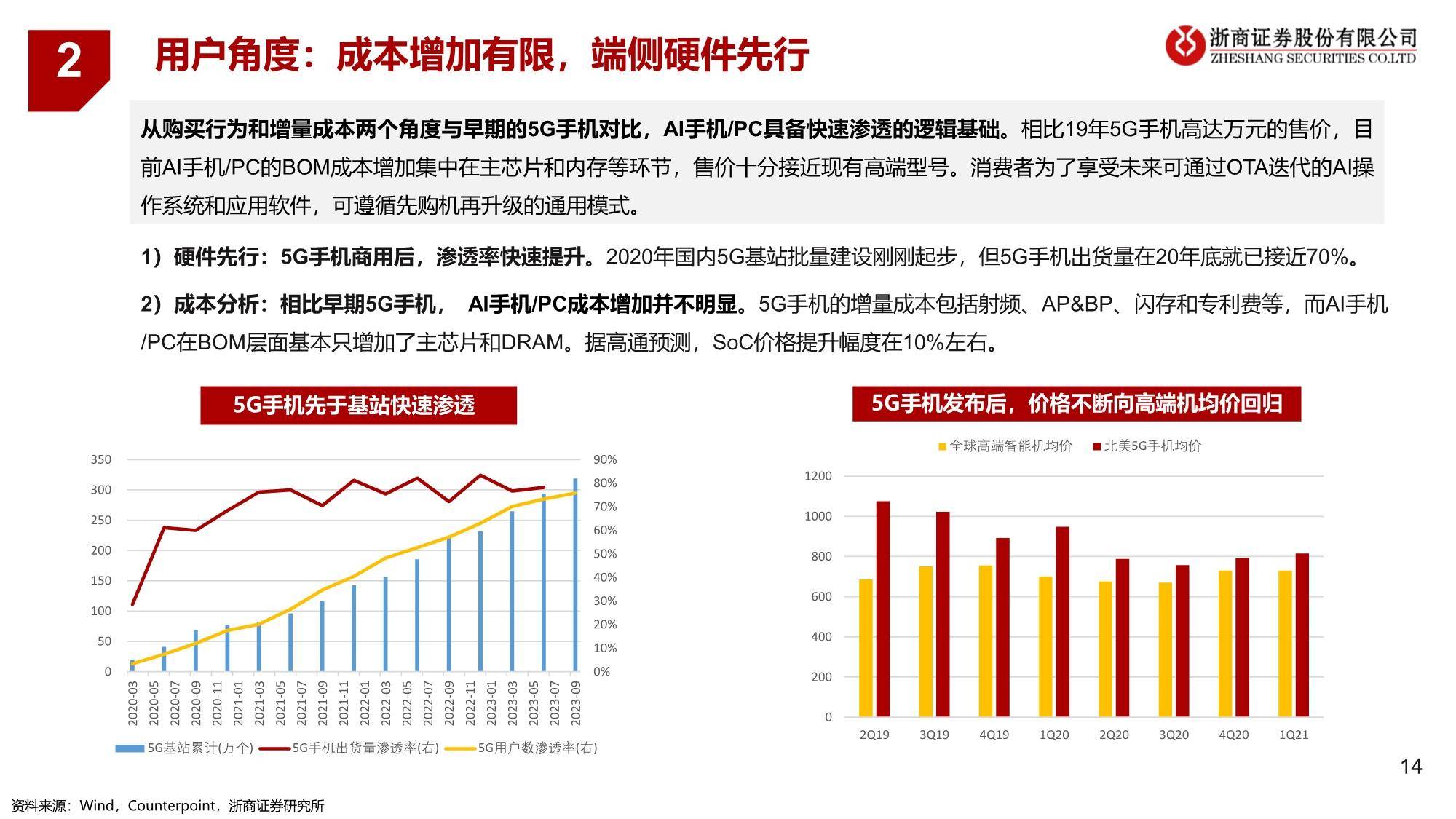

ChatGPT热潮席卷全球,云侧AI产业链史诗级爆发。ChatGPT (Chat Generative Pre-trained Transformer) 是由 OpenAI于2022年12月推出的对话AI模型,一经面世便受到广泛关注。获得千亿、万亿级别参数的大语言模型需要 超大规模AI服务器集群进行训练,且随着模型不断迭代,对云端算力的需求增加。2023年以来,以英伟达为代表的 AI芯片、通信网络和服务器产业链相关企业股价涨幅明显。

AI不止于云:端侧是模型应用不容忽视的重要场景

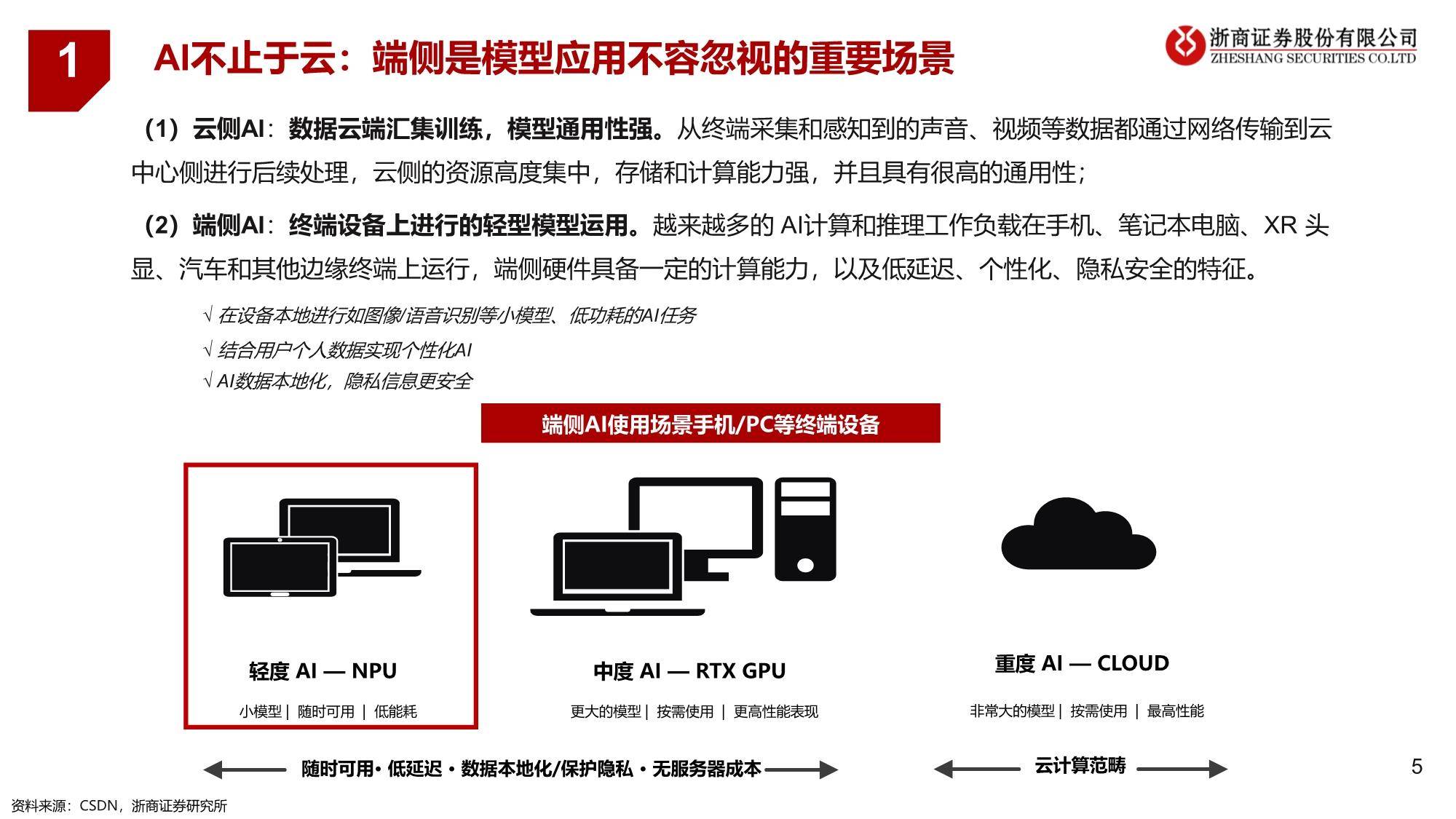

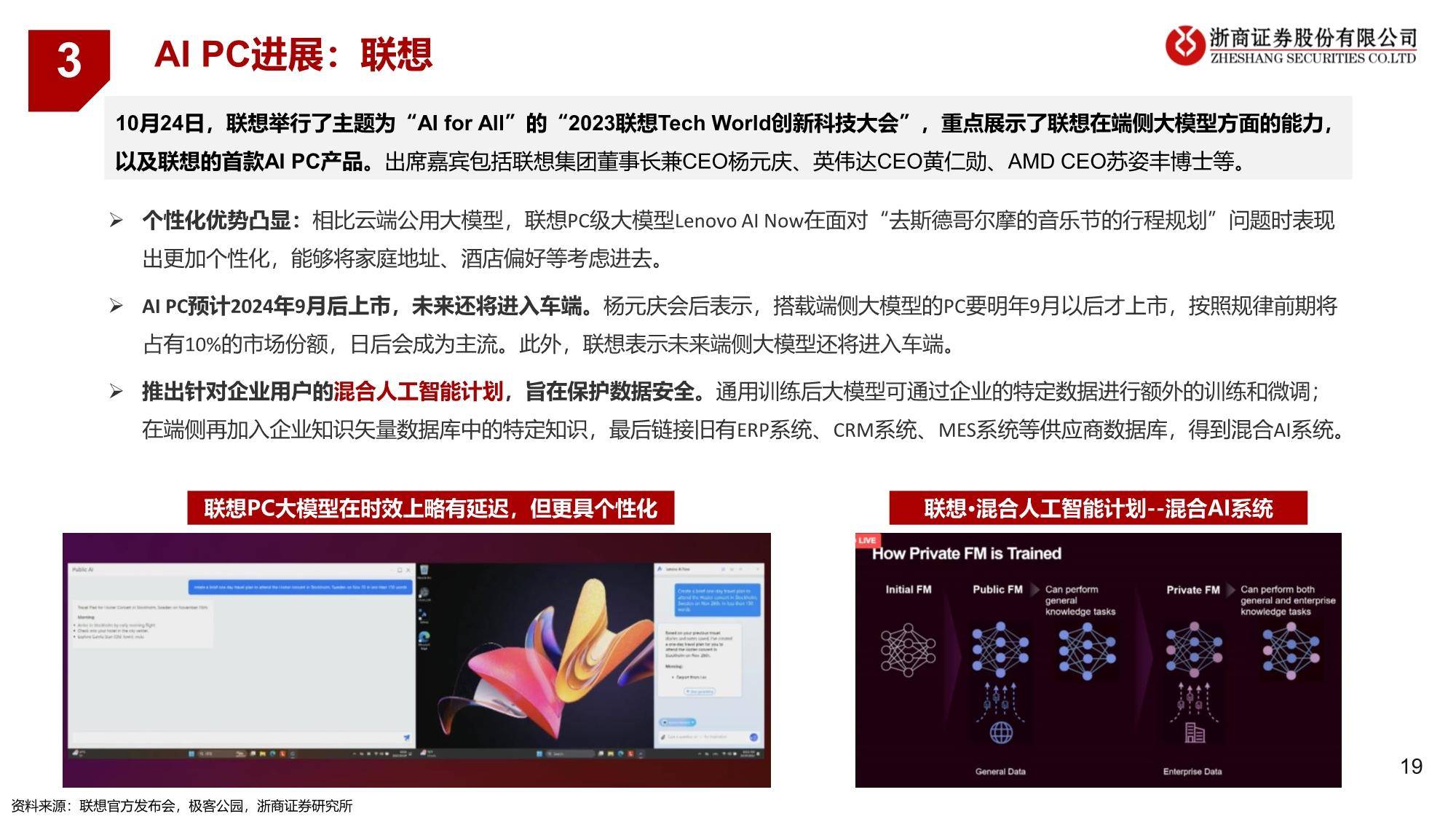

(1)云侧AI:数据云端汇集训练,模型通用性强。从终端采集和感知到的声音、视频等数据都通过网络传输到云 中心侧进行后续处理,云侧的资源高度集中,存储和计算能力强,并且具有很高的通用性;

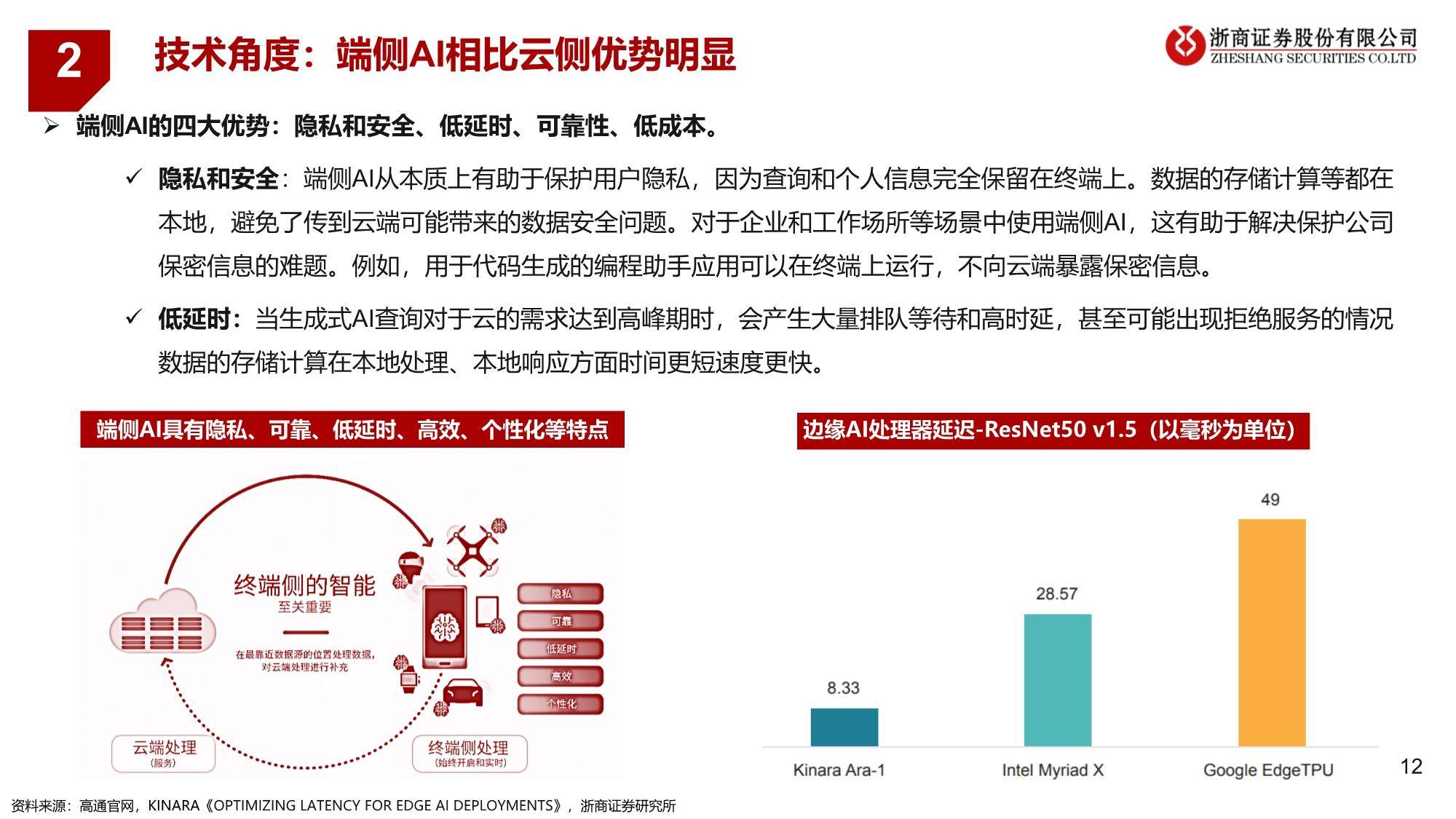

(2)端侧AI:终端设备上进行的轻型模型运用。越来越多的 AI计算和推理工作负载在手机、笔记本电脑、XR 头 显、汽车和其他边缘终端上运行,端侧硬件具备一定的计算能力,以及低延迟、个性化、隐私安全的特征。

混合AI大势所趋,AI处理重心向边缘转移

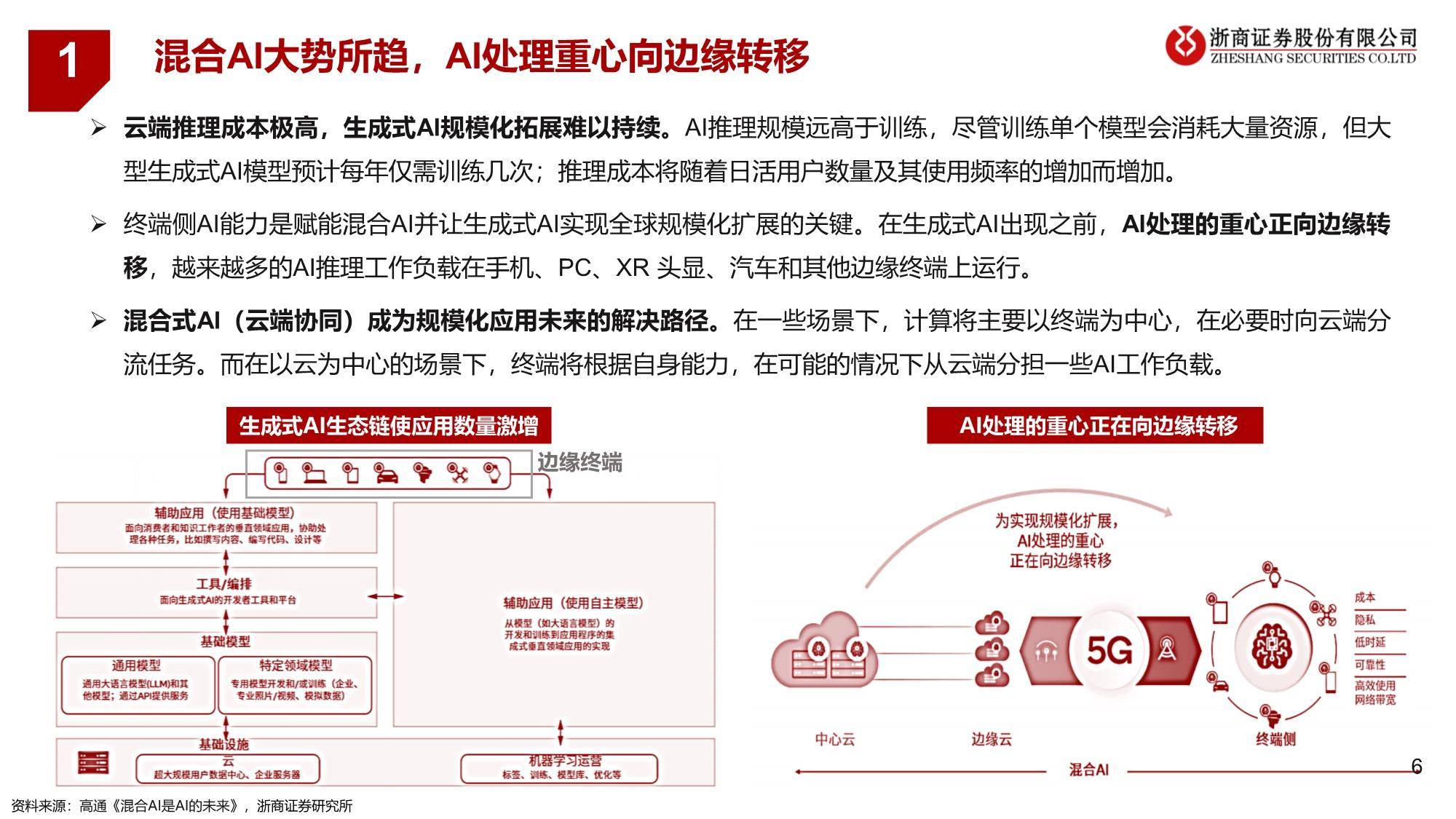

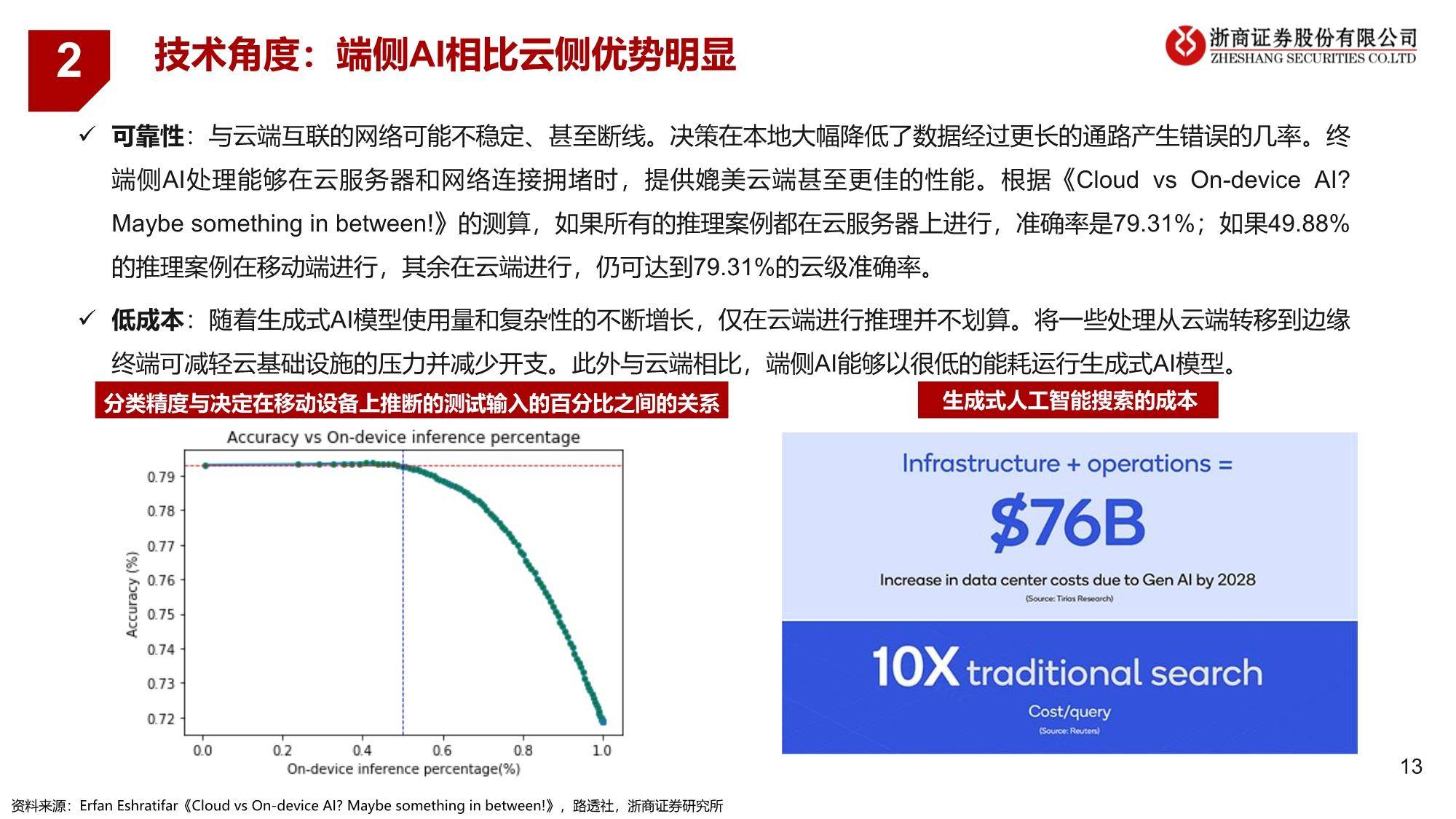

云端推理成本极高,生成式AI规模化拓展难以持续。AI推理规模远高于训练,尽管训练单个模型会消耗大量资源,但大 型生成式AI模型预计每年仅需训练几次;推理成本将随着日活用户数量及其使用频率的增加而增加。

终端侧AI能力是赋能混合AI并让生成式AI实现全球规模化扩展的关键。在生成式AI出现之前,AI处理的重心正向边缘转 移,越来越多的AI推理工作负载在手机、PC、XR 头显、汽车和其他边缘终端上运行。

混合式AI(云端协同)成为规模化应用未来的解决路径。在一些场景下,计算将主要以终端为中心,在必要时向云端分 流任务。而在以云为中心的场景下,终端将根据自身能力,在可能的情况下从云端分担一些AI工作负载。

场景丰富而深化,端侧AI无远弗届

端侧AI场景广泛,包括智能手机、PC、汽车、XR以及物联网等终端品类。不同产品类型也对芯片性能与成本提出更多的要求。

端侧AI落地的软硬件基础逐步夯实

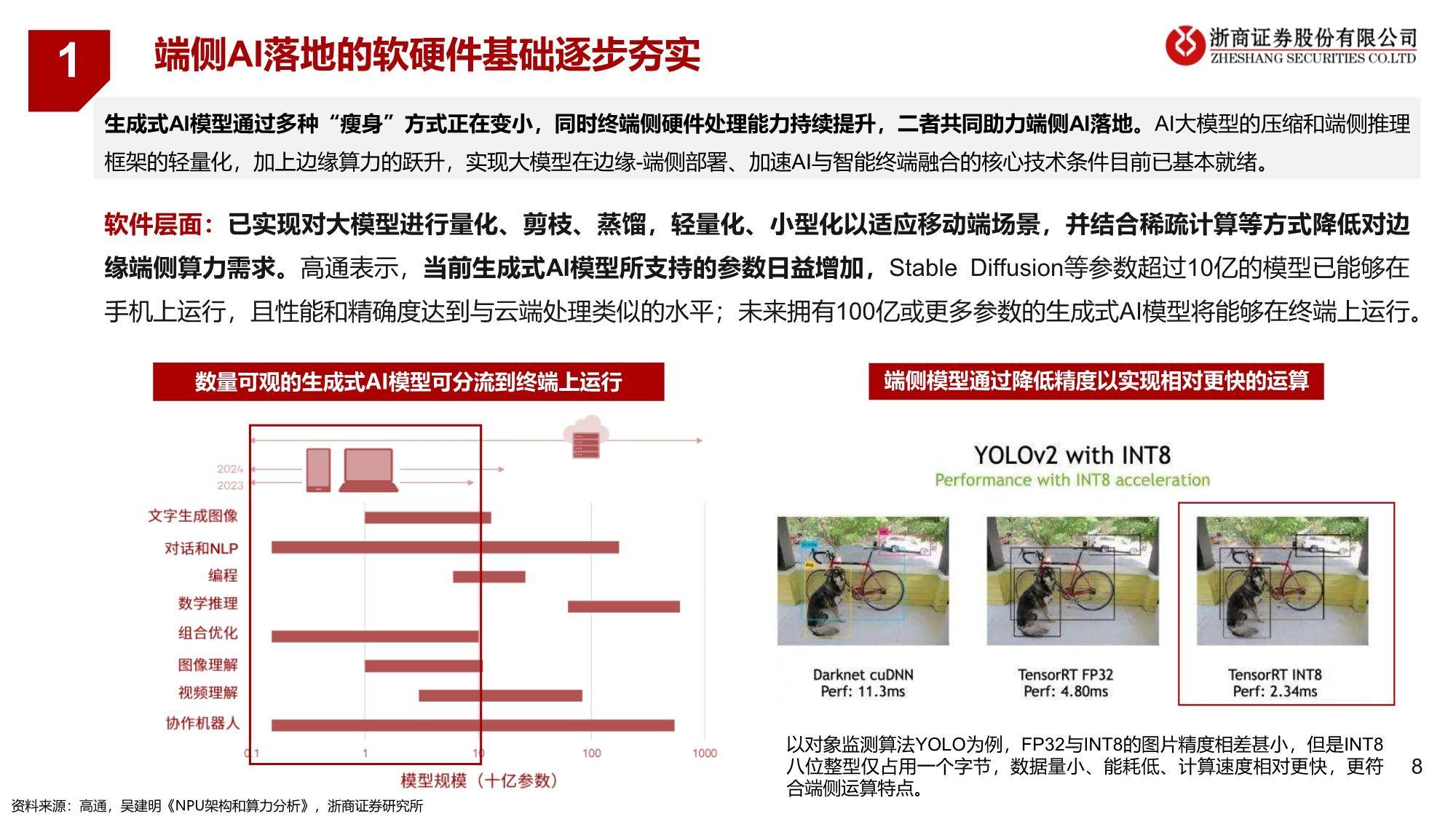

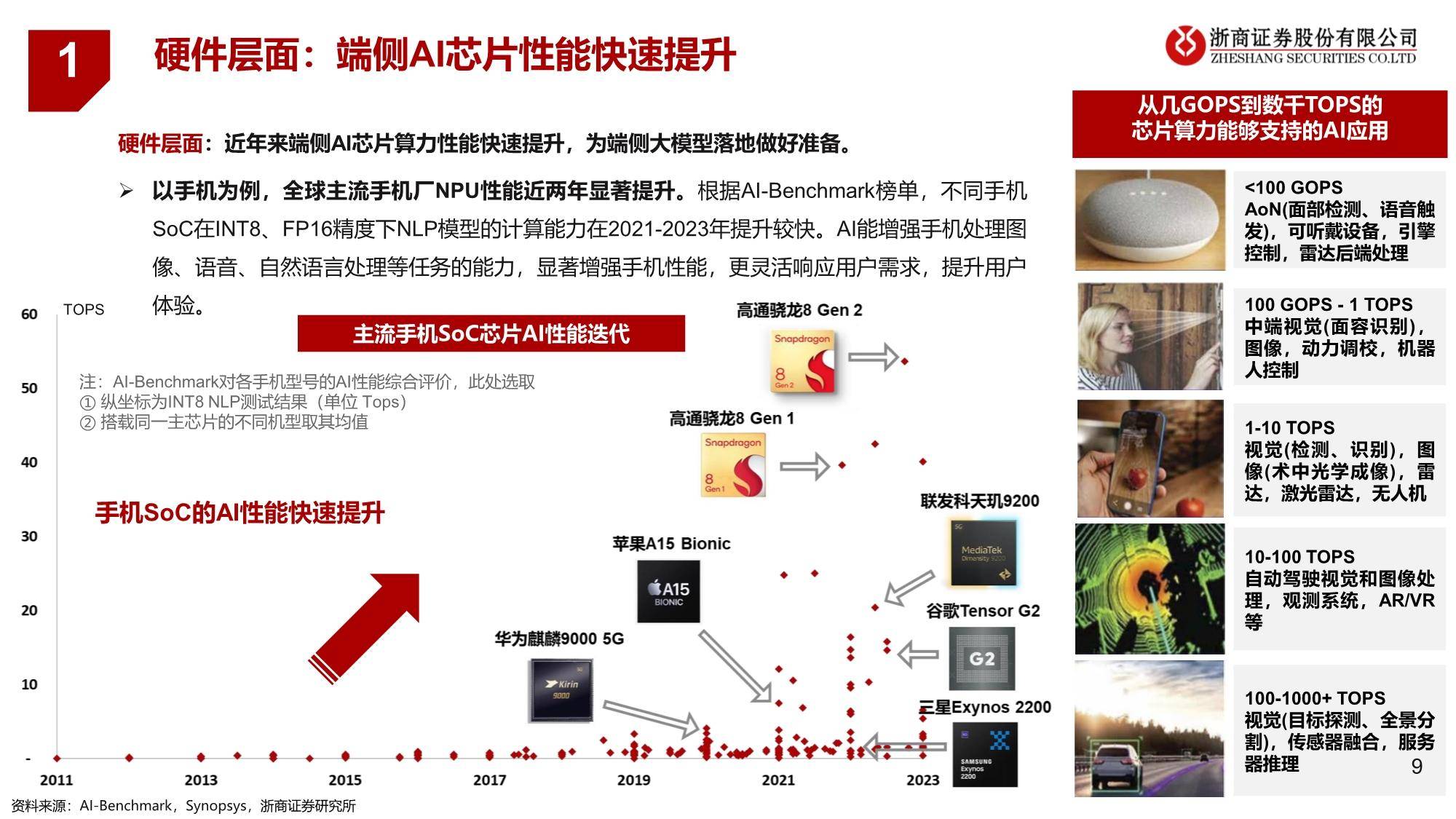

生成式AI模型通过多种“瘦身”方式正在变小,同时终端侧硬件处理能力持续提升,二者共同助力端侧AI落地。AI大模型的压缩和端侧推理 框架的轻量化,加上边缘算力的跃升,实现大模型在边缘-端侧部署、加速AI与智能终端融合的核心技术条件目前已基本就绪。

软件层面:已实现对大模型进行量化、剪枝、蒸馏,轻量化、小型化以适应移动端场景,并结合稀疏计算等方式降低对边 缘端侧算力需求。高通表示,当前生成式AI模型所支持的参数日益增加,Stable Diffusion等参数超过10亿的模型已能够在 手机上运行,且性能和精确度达到与云端处理类似的水平;未来拥有100亿或更多参数的生成式AI模型将能够在终端上运行。

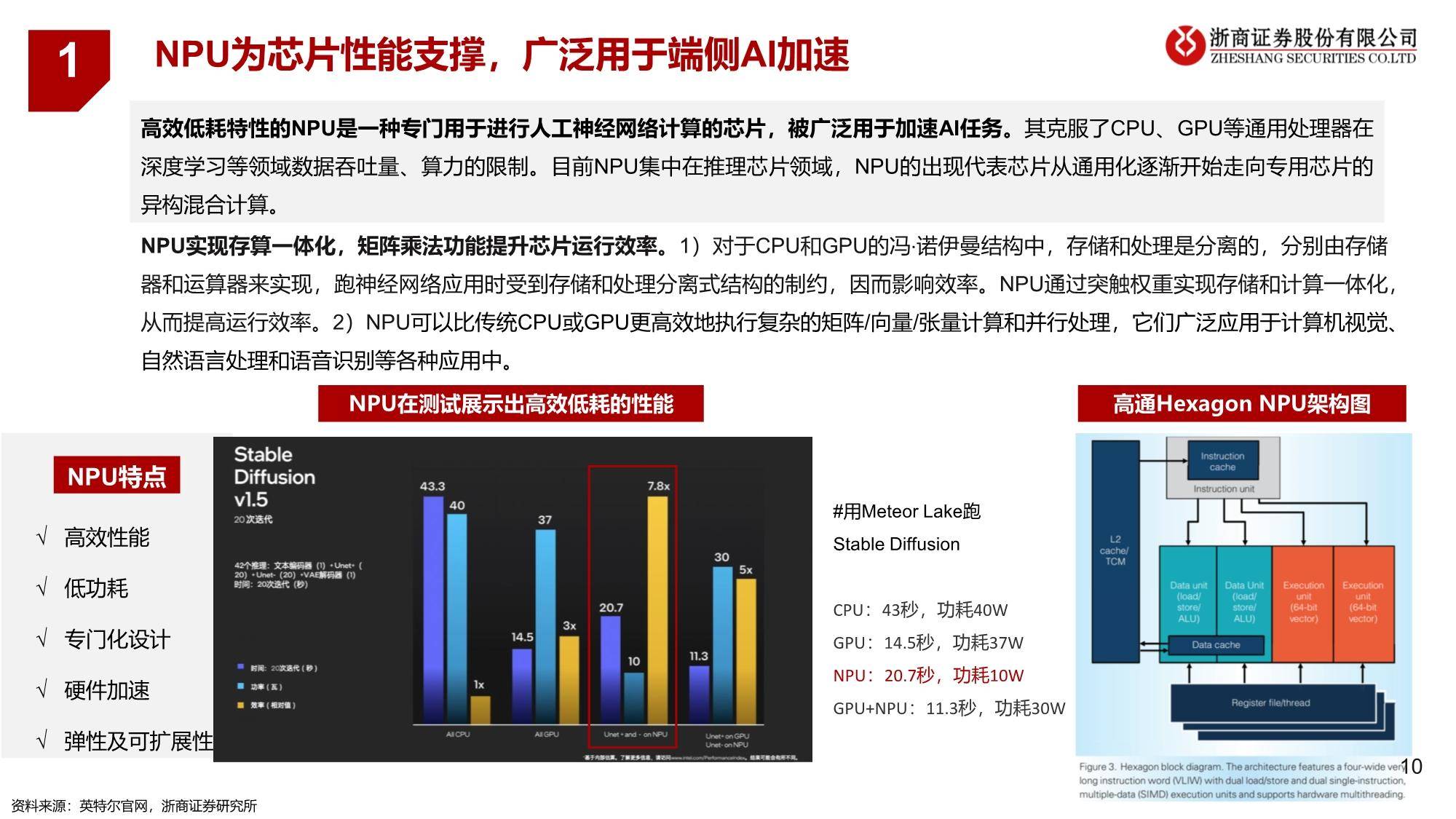

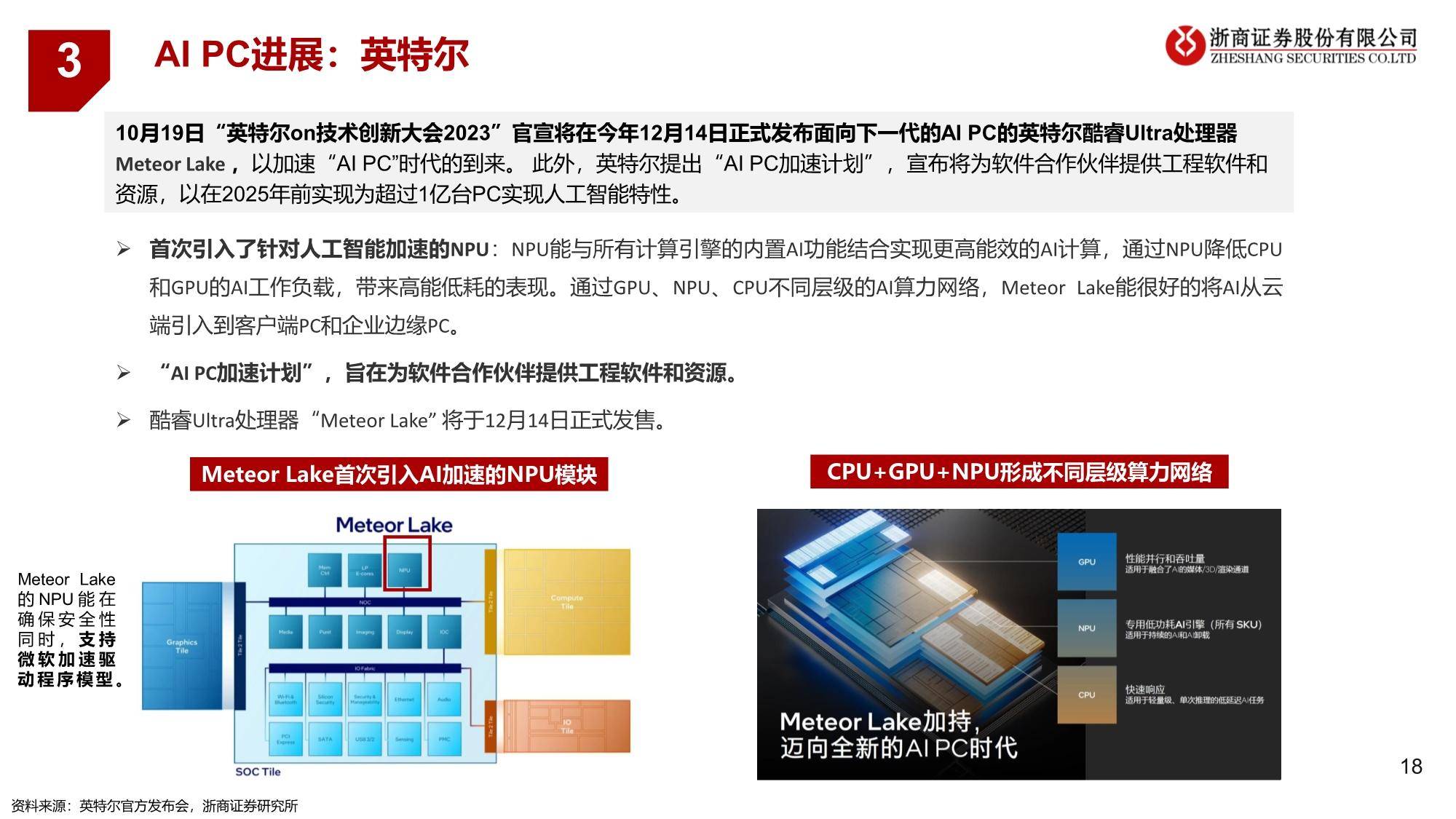

NPU为芯片性能支撑,广泛用于端侧AI加速

高效低耗特性的NPU是一种专门用于进行人工神经网络计算的芯片,被广泛用于加速AI任务。其克服了CPU、GPU等通用处理器在 深度学习等领域数据吞吐量、算力的限制。目前NPU集中在推理芯片领域,NPU的出现代表芯片从通用化逐渐开始走向专用芯片的 异构混合计算。

NPU实现存算一体化,矩阵乘法功能提升芯片运行效率。1)对于CPU和GPU的冯·诺伊曼结构中,存储和处理是分离的,分别由存储 器和运算器来实现,跑神经网络应用时受到存储和处理分离式结构的制约,因而影响效率。NPU通过突触权重实现存储和计算一体化, 从而提高运行效率。2)NPU可以比传统CPU或GPU更高效地执行复杂的矩阵/向量/张量计算和并行处理,它们广泛应用于计算机视觉、 自然语言处理和语音识别等各种应用中。

来源:浙商证券

报告内容节选如下: